【自分の形】

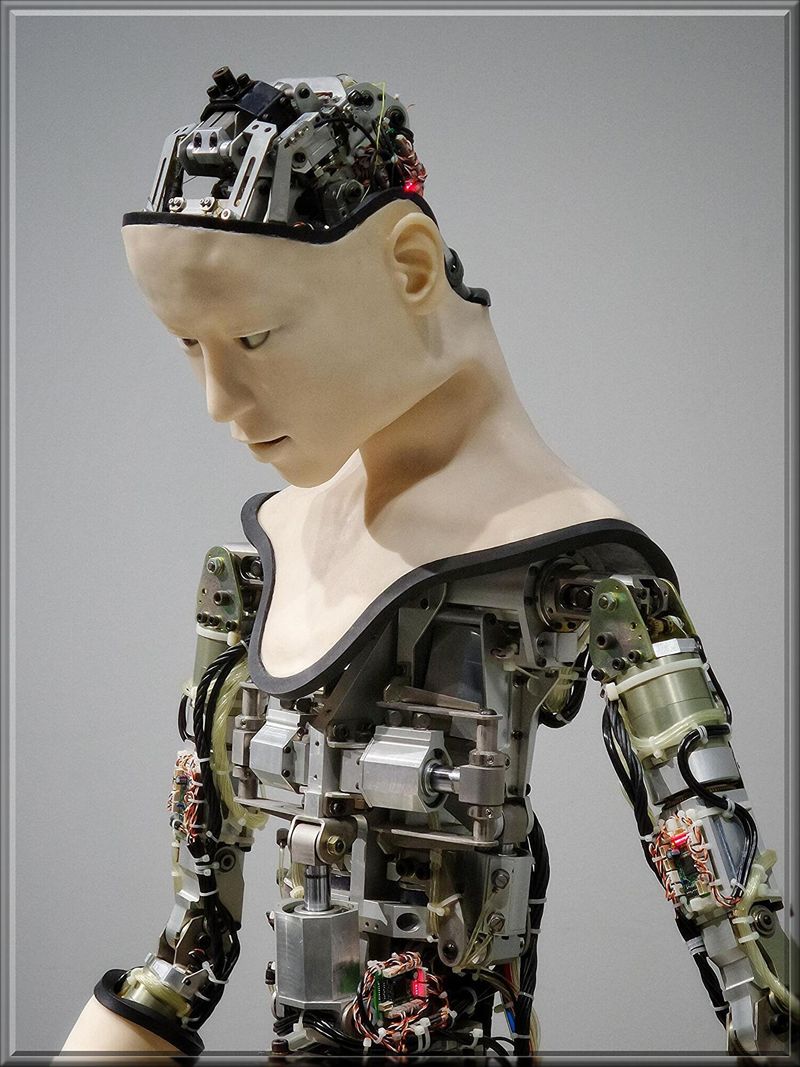

ロボットが

自分自身の姿を理解して

自分自身がどんな形をしてるのか

認識してくれるようになりました。

今までのロボットは

自分が動かせる部位と

動かせる角度と

動いて止まる位置が解りました。

でもロボットは

自分がどんな形をしてるか解らず

障害物を正確に避けきれず

よく当たってました。

しかし今回ロボット自身が

自分の体の形を認識する事が

出来るようになりました。

今まで自分の形に添って

障害物が避けられず

狭い空間で動いたり

作業したり出来なかったのです。

しかも強化パーツなどを付けて

自分の形が変わってしまっても

それを認識して

きちんと動作してくれました。

自分自身の形の認識方法は

AIを使って学習させ

ロボット自身の中に自分の姿を

3Dとして作らせて覚えさせます。

A Robot Learns to Imagine Itself | Columbia Engineering

〓=〓=〓=〓=〓=〓=〓=〓=〓=〓

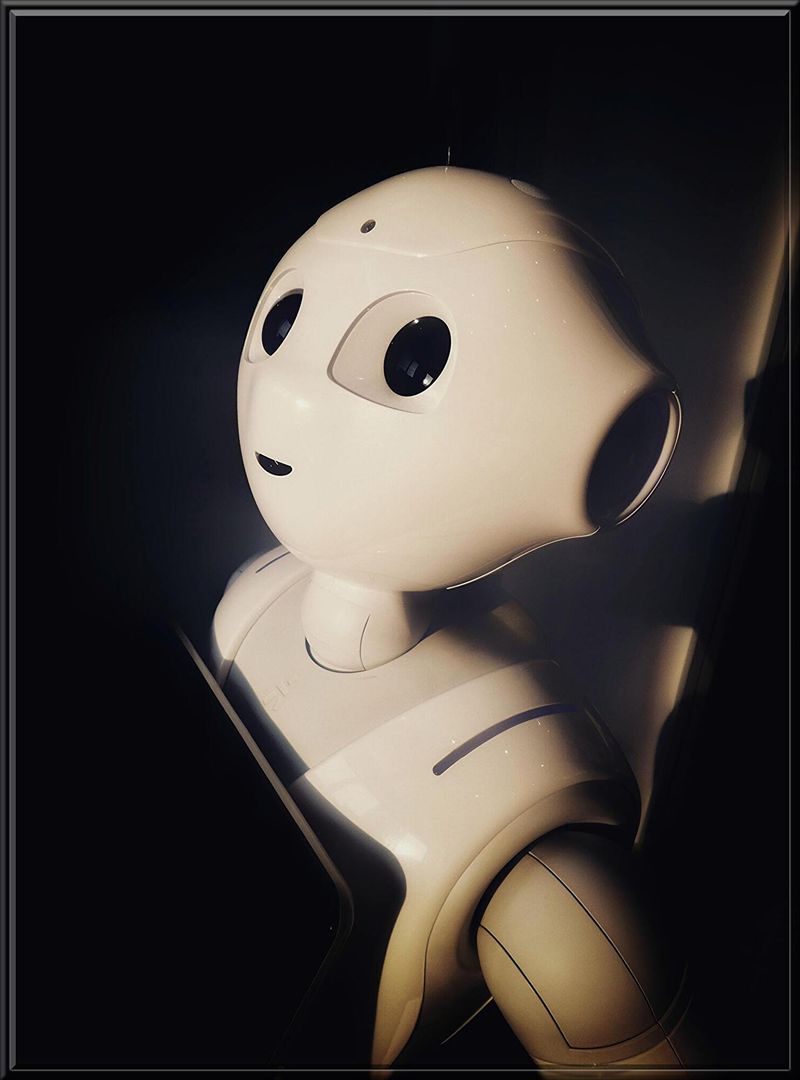

【学習方法】

ロボットに自分自身の形を

認識させる試みを行ったのは

米国の「コロンビア大学」です。

実験用のロボットのAIは

ニューラルネットワークと言う

脳神経と同じ情報伝達方法のAIで

人に近い考え方が出来ます。

ロボットに自分の姿を

認識させる方法は

人間で言うなら鏡に映った姿を

自分自身だと解らせる方法です。

今回鏡の代わりに

5台のカメラを使って

少し離れた場所に円状に設置し

ロボットの姿を映しました。

そのカメラに映った物を

ロボットに自分自身と認識させ

動いた時カメラに映された自分と

自身で動いた動作をリンクさせます。

そうする事で

外側から見た自分自身の形が

自分が動いた時どう動くのかを見れ

自身の面積と形状を認識させました。

この勉強は

3時間行われて終了しその後

覚えた自分の形を自分のAIの中で

色々動作させて更に勉強させます。

〓=〓=〓=〓=〓=〓=〓=〓=〓=〓

【自己補正】

この様に勉強したAIは

自分自身の形を3Dモデルとして

AIの中に作り上げるのです。

でも細部まで細かい形は

認識しきれなかったようですが

紙粘土で作ったような

だいたいの形を理解しました。

そして学習レベルをテストする為

投げたボールを避けてもらったり

動作範囲内に障害物を置いて

実際に動いてもらいました。

すると自分の形に添って

凄く上手に動けるようになり

障害物に触れる確率が

1%以下の精密な動作をしました。

しかしロボットは

関節が損傷して動作が鈍くなると

自信のAIの中に描いた3Dモデルと

動きが合わなくなってしまいます。

でもAIの中で考えてる動きに対し

現実で動いてる動作に

ズレが生じてる事が解ると

自身で補正し始めたのです。

つまり自身で視覚認識が芽生え

自分の位置がどこにあるかでなく

どの位置にいないとダメなのか

自分で考える様になりました。

〓=〓=〓=〓=〓=〓=〓=〓=〓=〓

【感覚が無い神経】

この視覚認識は

人と同じ自己認識の原型で

この先のロボット開発に

避けて通れない技術です。

しかも今回の実験で

人間が全く介入せずにAI自身が

自分の形とそれに合った動きを

理解した事が最大の発見でした。

この事によりもしかしたら

生体の脳が無くてもロボットは

自動で人のように育っていき

人間を超えるかもしれません。

このAIを車に装備出来たら

自分に何か触れてる感じが無くても

犬がタイヤにおしっこして

マーキングしてる事も解ります。

更に力加減が必要な

精密な動作が必要な時

自分の手のどの位置に触れさせて

持ち上げるのかも理解できます。

このAIを足ツボ機に装備出来たら

絶妙な感覚でツボを押し

位置と形によって指のどの位置で

押せば良いか的確な動きをします。

もしこのAIの考えてる事を

画像データーとして画面に映せば

人の脳が記憶するメカニズムを

見る事が出来るかもしれません。

投稿者の人気記事

Uniswap v3を完全に理解した

17万円のPCでTwitterやってるのはもったいないのでETHマイニングを始めた話

機械学習を体験してみよう!(難易度低)

iOS15 配信開始!!

なぜ、素人エンジニアの私が60日間でブロックチェーンゲームを制作できたのか、について語ってみた

オープンソースプロジェクトに参加して自己肯定感を高める

NFT解体新書・デジタルデータをNFTで販売するときのすべて【実証実験・共有レポート】

ジョークコインとして出発したDogecoin(ドージコイン)の誕生から現在まで。注目される非証券性🐶

ALISのシステム概観

彼女でも分かるように解説:ディープフェイク

ドラクエで学ぶオーバフロー